「今は音楽がスマートフォンで簡単にダウンロードできて便利だよね。」

「昔はカセットテープやレコードで音楽を聴いていたって知ってる?」

「それって、今のデジタル音源とは違うの?」

「最近はハイレゾ音源っていうのもよく聞くよね。何が違うんだろう?」

高等学校の「情報Ⅰ」の1分野「コミュニケーションと情報デザイン」の中で、「音のデジタル化」について学習します。

とはいうものの、

- デジタル化って何するの?

- 私たちの身近で音のデジタル化している例って何だろう?

と、あまりピンと来ていない人もいるかもしれませんね。

簡単に言いますと、「音のデジタル化」とは、私たちが普段耳で聞くことができるアナログの音を、コンピューターやデジタル機器が処理できるデジタル形式に変換する過程のことです。

この変換によって、音声はデジタルオーディオプレーヤーやスマートフォン、コンピュータなどで再生、編集、保存が可能になります。

こんにちは。学校の教育現場や情報科の授業内容について発信中!

10年近く高等学校の情報科の教員をしている、花音といいます。

-

- 幼少期からPCを触るのが大好き

- 数学が得意なバリバリ理系かと思いきや、読書も大好きな文系もいけるタイプ

- 高等学校の情報科の教員の経験あり

- 健康や美容、動物に関する動画を視聴するのが日常

皆さんの中には音楽を聴くことが好きな人もいるでしょう。

現代社会では、音楽をはじめとする多くの音がデジタル形式で提供されています。

ですが、CDやスマートフォンで音楽を聴くとき、その裏で行われているデジタル化という作業を意識することはあまりありません。

今回は、情報Ⅰの「音のデジタル化」で学ぶ内容について、皆さんの身の回りでよく聞くキーワード(ハイレゾ、5.1chサラウンド…など)にも触れながら、わかりやすく解説していきます。

以下の記事をお読みいただければ、ただ音のデジタル化について知ることができるだけでなく、身近な音についてもっと興味を持つことができますよ。

デジタル化の基本を理解することで、スマートフォンやコンピュータで音楽を聴くときだけでなく、デジタルオーディオの編集や加工するときなどにも役立てることができます。

それでは、音のデジタル化について学んでいきましょう!

アナログの音ってどんなもの? ~デジタル化の前に~

音は、物体の振動が空気の振動として人間の耳に届き、知覚細胞が刺激されて知

覚されます。

アナログの音とは、自然界に存在する音のことで、レコードプレーヤーやカセットテープなどで再生される音です。

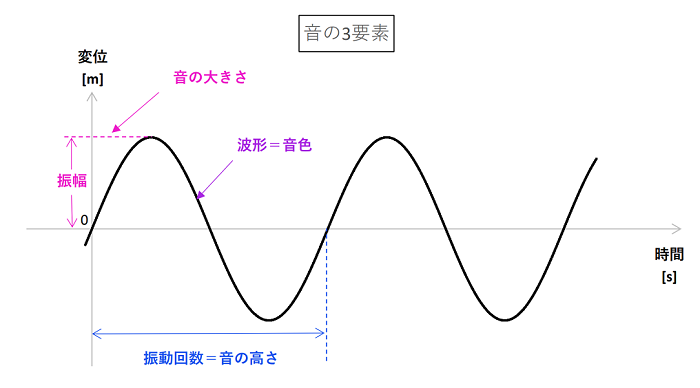

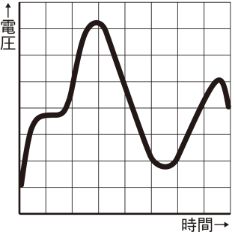

アナログの音 その1 ~音の3要素~

アナログの音は、

・音色

・音の高さ

・音の大きさ

の3要素から成り立っており、それらが波形に表されています。

音の3要素

(出典:防音室工事のBudscene「うるさい音は大きな音?音の3要素とは」)

音色

楽器や声が持つ独特の特徴のこと。

たとえば、ギターとピアノでは同じ音符を弾いても全く違う響きがしますよね。

これは、それぞれの楽器が発する振動の形が異なるためです。

音色は、楽器の材質や形、弾き方によって変わります。

音色は波の形状で表され、波の形状が異なれば違う音色ということになります。

音の高さ

音が高いか低いかを示すもの。

これは波の「周期」と振動の速さ、つまり「周波数」によって決まります。

一つの波が繰り返されるまでの時間のこと。

例えば、ギターの一本の弦を弾くと、弦は一定の速さで振動します。

この振動が一回完了するまでの時間が周期です。

周期が短いほど、つまり波がたくさん詰まっているほど、音は高くなります。

逆に、周期が長い、つまり波がゆったりとしているほど、音は低くなります。

1秒間に何回振動するかを数えたもの。単位はHz(ヘルツ)。

周波数が高いほど音の高さは高く、低いほど音の高さは低くなります。

音の高さを決めるのはこの周波数で、例えばピアノの高い音は周波数が高く、低い音は周波数が低くなります。

音の高さを決定するこれらの周期と周波数は、楽器の弦の長さや太さ、そして張力によって変わります。

弦が短くて細く、張力が高いほど、周期は短く、周波数は高くなり、結果として高い音が出ます。

反対に、弦が長くて太く、張力が低いほど、周期は長く、周波数は低くなり、低い音が出るわけです。

音の大きさ

音の強さや音量を意味するもの。

これは振動の幅、つまり「振幅」によって決まります。

波の振幅が大きいほど音は大きく、小さいほど音は小さくなります。

楽器を強く弾けば大きな音が、優しく弾けば小さな音が出ます。

アナログの音 その2 ~演奏方法による表現~

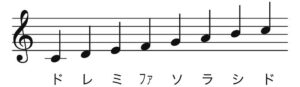

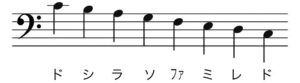

歌声や楽器で演奏された音を他の人に伝えたり、記録したりする方法として、「楽譜」があります。

楽譜の画像:http://pianofan.jp/read-music-score

(出典:PianoFan「ピアノの楽譜の読み方をわかりやすく簡単に解説【初心者向け】」)

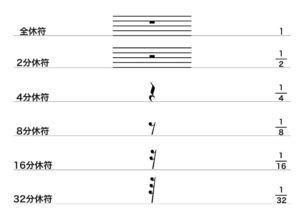

楽譜は、音楽の言語のようなもので、音の高さや長さ、強さ、そして演奏の仕方を視覚的に表現したものです。

例えば、ピアノの楽譜には、どの鍵盤をいつ、どのくらいの強さで押すかが書かれています。

また、ギターのタブ譜では、どの弦をどのフレットで押さえるかが数字で示されています。

楽譜には五線譜が使われることが多く、五本の横線とそれに交わる縦線で構成されています。

横線の上下の位置で音の高さが、縦線の間隔で音の長さが示されます。

そして、音符の形や付けられた記号によって、その音をどのように演奏するか(強く、弱く、速く、ゆっくりなど)が指示されます。

デジタルの音ってどんなもの? ~デジタル化していこう~

音のデジタル化 その1 ~音の要素からデジタル化~

音は、空気の振動が連続的に変化するアナログデータでしたね。

そのアナログデータは、以下の手順でデジタル化されます。

アナログデータ → 標本化 → 量子化 → 符号化 → デジタルデータ

音をこの手順でデジタル化することを、PCM[Pulse Code Modulation,パルス符号変調]と言います。

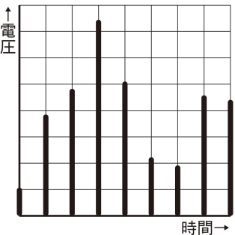

Step 1 標本化(サンプリング)

一定の時間間隔で音の強さを収集します。

区切る時間間隔。単位は[s(秒)]。

1秒間に標本化する回数。単位は[Hz(ヘルツ)]。

Step 2 量子化

収集した音の強さを数値に変換します。

この段階で連続的な音データが、離散的な数値になります。

量子化ビット数

量子化した値の2進法のビット数。

Step 3 符号化(コード化)

Step 2で量子化した数値を2進法に変換します。

![]()

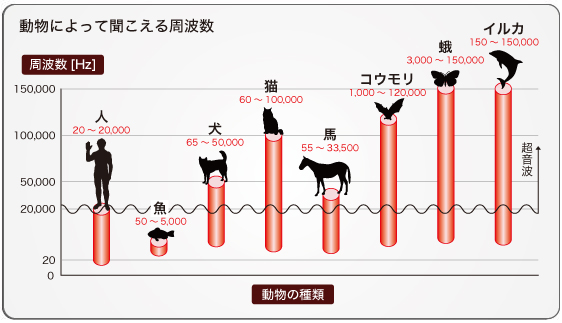

参考 主な動物が「知覚できる音域」(=可聴帯域)

人間の耳の可聴帯域は、20Hz~20,000Hzと言われています。

(出典:音の雑学大辞典「第1章 音のひみつ」)

それに対し、イルカやコウモリなどの動物は人間に聞こえない周波数の音も聞こえてます。

例えば、数頭から数十頭の群れで生活することが多いイルカは、「キリキリ」「キチキチ」といったクリック音や「ピーピー」といったホイッスル音と呼ばれる高周波音を発して、仲間同士でコミュニケーションを取ることが知られています。

(出典:ネイチャーテック研究会のすごい自然のショールーム「イルカの音響定位に学ぶ新しい水中音響通信」)

とはいえ、人間にはこのような高周波音は聞こえません。

このような人間の限界を超える周波数の音をカットすることで、符号化に用いるビット数を減らすことができます。

また、符号化されたデータから元の値を予測することで、標本化(サンプリング)の幅を小さく見せかける工夫も開発されています。

このように、音の劣化を感じさせないようにデータの量を減らす工夫が考えられています。

ここ数年、「レコード」の人気が高まっています。

レコードはデジタルではなく、アナログの音なんですね。

アナログの音 ~レコードやカセットテープ~

レコードは、音そのものの振動を物理的な溝(レコード盤の表面にある細かい線)として記録しています。

針がこれらの溝を読み取ることで、音が再生されるわけです。

この方法では、音の微妙なニュアンスや、演奏時の空気感まで捉えることができるため、音に「暖かみ」や「生々しさ」が感じられると言われています。

カセットテープは、磁気テープに音の情報をアナログ形式で記録するメディアです。

音は物理的な形(磁気の変化)でテープに保存され、テープを再生することで音が出力されます。

カセットテープの音質は、テープの品質や保存状態、再生機器の性能に大きく依存します。

また、テープは時間が経つと劣化しやすく、繰り返し再生することで音質が低下することもあります。

カセットテープの音は、アナログならではの温かみがあるとも言われていますが、ヒスノイズ(背景に聞こえるシーンという音)などのノイズが入ることも特徴です。

一方で、デジタル配信されている音楽は、音をサンプリングという方法で一定間隔ごとに測定し、それを数字に変換して記録しています。

このデジタル化された音楽は非常にクリアで、ノイズが少ないのが特徴ですが、アナログ音源のような「温かみ」は少ないと感じる人もいます。

つまり、レコードやカセットテープの音は、音楽が持つオリジナルの「雰囲気」を大切にしていると言えます。

それに対して、デジタル音楽は「正確さ」や「クリアさ」を重視していると言えるでしょう。

音楽を聴くときの環境や好みによって、レコードやカセットテープの音を好む人もいれば、デジタル音楽のクリアな音を好む人もいます。

あなたはどちらの音が好きですか?

ここ数年、「レコード」の人気が高まっています。

CDやインターネット上で配信されている音楽よりも「音に暖かみや丸みがある」といったことが理由のようです。

私たちは、人間の可聴帯域の外の音を(耳以外も含めて)感じ取っているのかもしれませんね。

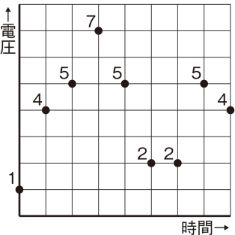

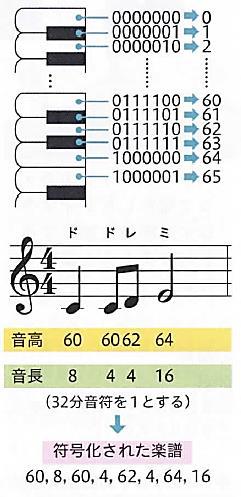

音のデジタル化 その2 ~演奏方法からデジタル化~

デジタル化の方法には、PCM方式とは別に、演奏方法をデータ化するMIDI[Musical Instrument Digital Interface]という規格があります。

音色の種類や音の高さ、長さ、大きさ、テンポなどの演奏情報を楽譜のようにデータ化(=「符号化」)して記録します。

再生するときには、楽器となる音源(ピアノ、ギターなど)が必要になります。

この方法は、PCM方式に比べて小さなデータ量で曲を記録できます。

(出典:日本文教出版「情報Ⅰ」)

音のデータ量の求め方

例えば、CDのデータ量を求めてみましょう。

一般的なCDの標本化周波数は44.1kHz(キロヘルツ)、つまり44100Hzです。

量子化ビット数は16ビット、チャンネル数は、ステレオであれば2(左と右)、モノラルであれば1です。

時間は、録音された音の長さを秒で表します。

この公式を使って、音のデータ量を計算する際には、これらの値を掛け合わせた後、8で割ることを忘れないようにしましょう。

8で割る理由は、1バイトが8ビットであるためです。

それを踏まえて、CD品質の音(標本化周波数:44.1kHz、量子化ビット数:16ビット、チャンネル数:ステレオ=2チャンネル)で1分間の音のデータ量を計算すると、

44,100×16×2×60÷8=8,467,200バイト

となります。これをメガバイト(MB)に変換すると、

8,467,200÷(1,024×1,024)≒8.08MB

となります。これが1分間のCD品質の音のデータ量です。

この公式を使って、異なる標本化周波数や量子化ビット数、チャンネル数での音のデータ量を計算してみると良いでしょう。

それによって、音質とデータ量の関係についての理解が深まります。

チャンネル数

チャンネル数を考えるときに出てきた、「ステレオ」と「モノラル」は、音楽や音声を聴くときの音の出し方の違いを指します。

1チャンネル:モノラル

モノラル

「単一の音」という意味。

モノラルの音源では、左右のスピーカーから全く同じ音が出ます。

これは、まるであなたが人と直接話しているときのように、音が一つの方向から聞こえてくるということです。

昔のラジオ放送や初期の音楽録音はモノラルでした。

モノラルはシンプルで、どこにいても同じ音が聞こえるのが特徴です。

2チャンネル:ステレオ

ステレオ

「立体的な音」という意味。

左右のスピーカーから異なる音が出ます。

これにより、音に広がりが生まれ、例えば音楽を聴いていると、ドラムは左から、ギターは右から聞こえてくるような、実際のライブのような立体感を感じることができます。

ステレオは、音が複数の方向から聞こえるため、よりリアルで臨場感のある音の体験を提供します。

簡単に言うと、モノラルは「一つの大きな声」で、ステレオは「いろいろな方向からの複数の声」のようなものです。

映画館やコンサートホールでの音響体験を考えると、ステレオの方がより現実に近い音の体験を提供してくれるということがわかります。

普段聴いている音楽のほとんどはステレオで録音されているため、左右のイヤホンやヘッドフォンを使って聴くと、その違いを体感できるでしょう。

映画館のチャンネル数

映画館でよく見かける「5.1chサラウンド」や「7.1chサラウンド」というのは、映画の音響システムのことです。

ステレオと比べてさらに多くのスピーカーを使って、よりリアルで包み込まれるような音の体験を提供します。

5.1chサラウンド

「5.1chサラウンド」は、5つのフルレンジのスピーカー(フロント左、フロント中央、フロント右、リア左、リア右)と、1つのサブウーファー(低音を出すスピーカー)で構成されています。

これにより、前後左右から音が聞こえ、映画のアクションシーンで飛行機が頭上を飛び越えるような音や、後ろから近づいてくる足音など、映画の中にいるような感覚を味わえます。

7.1chサラウンド

「7.1chサラウンド」は、5.1chサラウンドにさらに2つのスピーカーを加えたもので、これにより音の方向性がさらに細かくなります。

7.1chでは、リアのスピーカーが左右に2つずつあり、より正確な位置から音が聞こえるようになります。

これにより、映画の中の環境音や細かい音の動きがよりリアルに感じられるようになります。

要するに、ステレオが「左右からの音」であるのに対し、5.1chや7.1chサラウンドは「全方位からの音」で、映画の世界に没入できるような音の体験を提供します。

映画館では、これらのサラウンドシステムを使って、観客が映画の世界に完全に入り込めるような環境を作り出しています。

ハイレゾ音源

音楽を聴く人は、ハイレゾという言葉を耳にすることがあるでしょう。

ハイレゾ音源とは、高解像度の音楽ファイルのことです。

CDや一般的なデジタル音楽配信で聴くことができる音質よりもさらに細かい情報を含んでいる音楽データです。

では、まず想像してみてください。

音楽を絵画に例えるなら、ハイレゾ音源はとても細かい筆で丁寧に描かれた絵のようなものです。

一方で、CDの音質はもう少し大きな筆で描かれた絵、そしてMP3のような圧縮された音楽ファイルはさらに大ざっぱな筆使いの絵といえます。

ハイレゾ音源では、より多くの「色」や「線」の細かい部分が表現されているため、よりリアルで豊かな音の風景を感じることができるのです。

具体的には、ハイレゾ音源は以下のような特徴を持っています。

1. 高い標本化周波数(サンプリングレート)

標本化周波数とは、1秒間にどれだけの回数音を記録するかを表す数値でしたね。

CDの音質は44.1kHz(キロヘルツ)ですが、ハイレゾ音源はそれを超える96kHzや192kHzなどを使用しています。

これにより、より細かい音の変化を捉えることができ、より自然でリアルな音を再現できます。

2. 高い量子化ビット数

量子化ビット数とは、音の強さの変化をどれだけ細かく記録するかを表す数値でしたね。

CDは16ビットですが、ハイレゾ音源は24ビットを使用することが多く、より微細な音の強さの違いを捉えることができます。

たとえば、標本化周波数:192kHz、量子化ビット数:24ビットのハイレゾ音源の場合、CD(44.1kHz、16ビット)の約6.5倍の情報量をもっていることになります。

(出典:SONY「ハイレゾとは?」)

3. 豊かな音の情報量

ハイレゾ音源は、より多くの音の情報を含んでいるため、楽器の微妙な響きや空気感、音の立体感など、生の演奏に近い音質を体験することができます。

ハイレゾ音源を聴くためには、ハイレゾに対応した再生機器やヘッドフォン、スピーカーが必要です。

しかし、それらを用いることで、まるでコンサートホールにいるかのような、臨場感あふれる音楽体験をすることができます。

普通のCD音源と比較してみると、より音楽を深く楽しめるでしょう。

音のデジタル化の世界

音のデジタル化は、アナログの音の波をデジタルデータに変換する過程でしたね。

- 標本化、量子化、符号化

- 標本化周波数、標本化周期、量子化ビット数

- PCM、MIDI

- ハイレゾ

- モノラル、ステレオ、5.1chサラウンド、7.1chサラウンド

- レコード、カセットテープ

今回の音のデジタル化の話では、さまざまなキーワードが出てきました。

身近なところにも、アナログの音とデジタルの音が見つけられたかと思います。

ただ、これだけは知っておいてください。

デジタルというと、アナログより優れていると考えてしまう人もいるかもしれません。

ですが、そうではありません。

デジタル化する際の標本化周波数や量子化ビット数の大きさ次第で、元のアナログデータに近くデジタル化できる場合と、そうでない場合があるのです。

デジタル化する際は気を付けていきたいですね。

本日学習した「音のデジタル化」は聴く体験を豊かにしてくれるものです。

「音のデジタル化」の知識をしっかり持って、こういった音に触れてみると、音を聴くのももっと楽しくなるかもしれませんね。

コメント